Le démantèlement des installations nucléaires pose des défis majeurs aux exploitants. Qu’il s’agisse de démantèlement ou de confinement sécurisé : la quantité de déchets nucléaires à éliminer augmente à un rythme effréné dans le monde entier. L’automatisation est de plus en plus nécessaire dans la manipulation des déchets nucléaires, mais l’industrie nucléaire se méfie des méthodes de commandes robotiques totalement autonomes pour des raisons de sécurité les robots industriels télécommandés sont préférés dans les environnements dangereux. Cependant, des tâches aussi complexes que la saisie ou la découpe télécommandée d’objets inconnus à l’aide de joysticks et de caméras de vidéosurveillance sont difficiles et parfois même impossibles à contrôler.

Le démantèlement des installations nucléaires pose des défis majeurs aux exploitants. Qu’il s’agisse de démantèlement ou de confinement sécurisé : la quantité de déchets nucléaires à éliminer augmente à un rythme effréné dans le monde entier. L’automatisation est de plus en plus nécessaire dans la manipulation des déchets nucléaires, mais l’industrie nucléaire se méfie des méthodes de commandes robotiques totalement autonomes pour des raisons de sécurité les robots industriels télécommandés sont préférés dans les environnements dangereux. Cependant, des tâches aussi complexes que la saisie ou la découpe télécommandée d’objets inconnus à l’aide de joysticks et de caméras de vidéosurveillance sont difficiles et parfois même impossibles à contrôler.

Pour simplifier ce processus, le centre national de robotique nucléaire, dirigé par l’Extreme Robotics Lab de l’université de Birmingham au Royaume-Uni, étudie des options de manipulation automatisée pour le tri et la séparation des déchets nucléaires. Le système d’assistance robotique qui y a été développé permet une commande « partagée » pour effectuer des tâches de manipulation complexes grâce à un retour tactile et à des informations d’image fournies par une caméra 3D Ensenso. De cette façon, l’opérateur garde à tout moment le contrôle des actions automatisées du robot et peut intervenir en cas de défaillance du système.

Si vous avez déjà essayé une machine à pince de foire, vous pouvez le confirmer : la commande manuelle des bras de préhension est tout sauf banale. Autant il y a peu de risques à échouer en essayant d’enlever un lapin en peluche, autant les tentatives ratées de manipulation de déchets radioactifs peuvent être dramatiques. Pour éviter des dommages aux conséquences graves pour l’homme et l’environnement, le robot doit être capable de détecter les objets radioactifs présents avec une extrême exactitude et d’agir avec précision. L’opérateur l’a littéralement dans les mains, c’est à lui d’identifier les bonnes positions de préhension.

Dans le même temps, il doit évaluer correctement la cinématique inverse (rétrotransformation) et déterminer correctement les angles d’articulation des éléments du bras du robot afin de le positionner correctement et d’éviter les collisions. Le système d’assistance développé par les chercheurs britanniques simplifie et accélère énormément cette tâche : il comprend un robot industriel standard équipé d’une pince à mâchoires parallèles et d’une caméra 3D Ensenso N35.

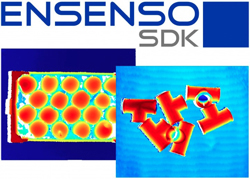

Le système scanne de manière autonome les déchets inconnus et crée à partir de cette numérisation un modèle 3D sous la forme d’un nuage de points. Cette modélisation est extrêmement précise, car les caméras 3D Ensenso fonctionnent selon le principe de la vision spatiale (stéréovision), qui est inspirée de la vision humaine. Deux caméras visualisent un objet selon des positions différentes. Même si le contenu des images des deux caméras semble identique, il existe des différences au niveau de la position des objets observés. Étant donné que la distance et l’angle d’observation des caméras ainsi que la focale des optiques sont connus, le logiciel Ensenso peut déterminer les coordonnées 3D du point objet de chaque pixel de l’image. Dans ce cas, la scène est capturée en utilisant différentes positions de balayage de la caméra et en les combinant pour obtenir une surface 3D complète sous tous les angles. Les routines de calibrage d’Ensenso aident à transformer les nuages de points individuels en un système de coordonnées global, ce qui améliore la représentation virtuelle complète. Le nuage de points qui en résulte contient donc toutes les informations sur l’objet spatial nécessaires pour transmettre au robot la bonne position de préhension ou de coupe.

Avec l’aide du logiciel, la caméra 3D Ensenso prend ainsi en charge la perception et l’évaluation des informations de profondeur pour l’opérateur, dont la charge cognitive est ainsi considérablement réduite. Le système d’assistance combine les caractéristiques haptiques de l’objet à saisir avec un algorithme de préhension spécial. Le nuage de scène est utilisé par notre système pour générer automatiquement plusieurs positions de préhension stables.

"Comme les nuages de points capturés par la caméra 3D sont de haute résolution et denses, il est possible de produire des positions de préhension très précises pour chaque objet de la scène." Dr. Naresh Marturi, Senior Chercheur au Centre National de Robotique Nucléaire.

« Sur cette base, notre « algorithme de classement des hypothèses » détermine le meilleur objet à saisir en fonction de la position actuelle du robot », explique Naresh Marturi, chercheur senior au Centre national de robotique nucléaire.

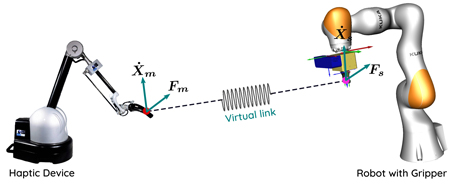

Le principe est similaire à celui du jeu d’adresse Mikado, où il faut retirer un bâton l’un après l’autre sans déplacer les autres bâtons. Le guidage de la trajectoire déterminée permet au robot de naviguer en douceur et de façon régulière le long d’une trajectoire souhaitée jusqu’à la position de préhension cible. Comme un système de navigation, le système aide l’opérateur à guider le bras du robot vers une prise sûre, si nécessaire en passant également devant d’autres objets inconnus et dangereux. Le système calcule pour cela un couloir sûr et aide l’opérateur à ne pas quitter le couloir grâce à un retour d’information tactile.

Le système reproduit les mouvements naturels de la main de l’opérateur de manière précise et fiable en temps réel sur les mouvements correspondants du robot. « À ce stade, l’opérateur commande le robot en utilisant uniquement le dispositif haptique. Si le robot s’écarte de la trajectoire souhaitée, l’opérateur s’en rend compte par l’intermédiaire de la poignée et peut ramener le robot sur la trajectoire. Lorsque le robot atteint la position de préhension, l’opérateur ressent une forte résistance dans la poignée du dispositif haptique qui l’empêche de déplacer le robot. » L’opérateur conserve ainsi toujours la commande manuelle et est en mesure de prendre le relais en cas de défaillance d’un composant. Il peut simplement désactiver l’IA et revenir à l’intelligence humaine en arrêtant le « mode retour de force ». Selon le principe de la commande partagée entre l’homme et la machine, le système reste ainsi sous contrôle à tout moment ce qui est essentiel dans un environnement présentant le plus haut niveau de danger.

« Pour toutes nos tâches de planification de saisie autonome, de commande à distance et de suivi visuel d’objets, nous utilisons le modèle de caméras 3D Ensenso N35 avec des LED bleues (465 nm) montées sur l’effecteur final des robots avec d’autres outils », déclare Naresh Marturi. Jusqu’à présent, la plupart des systèmes d’Extreme Robotic Lab ont été équipés d’une seule caméra 3D. « Toutefois, pour accélérer encore le processus de modélisation 3D, les systèmes ont récemment été mis à niveau et utilisent désormais trois caméras 3D Ensenso supplémentaires en plus de la caméra montée sur le robot. »

La série Ensenso N est prédestinée à cette tâche. Elle a été spécialement conçue pour une utilisation dans des conditions environnementales difficiles. Grâce à sa forme compacte, la série N, de faible encombrement en version immobile ou mobile sur un bras de robot, convient aussi bien à l’acquisition 3D d’objets statiques ou en mouvement. Même dans des conditions de luminosité difficiles, le projecteur intégré projette au moyen d’un masque de motif de points aléatoire une texture très contrastée sur l’objet à représenter et compense ainsi sur ses surfaces le manque ou l’absence de structures. Le boîtier en aluminium des modèles N30 garantit une dissipation thermique optimale des composants électroniques et donc un rendement lumineux stable même dans des conditions environnementales extrêmes. Une qualité supérieure constante est ainsi assurée tout comme la fiabilité des données 3D. Même dans des conditions de luminosité difficiles, le projecteur intégré projette au moyen d’un masque de motif de points aléatoire une texture très contrastée sur l’objet à représenter et compense ainsi sur ses surfaces le manque ou l’absence de structures.

Les caméras de la gamme N Ensenso sont aisées à configurer et à utiliser grâce au kit de développement logiciel Ensenso. Ce dernier offre un traitement d’image basé sur le GPU pour un traitement des données 3D encore plus rapide et permet la production d’un seul nuage de points 3D de toutes les caméras utilisées dans les applications à caméras multiples ainsi que la composition en direct de nuages de points 3D de différentes perspectives.

Pour le système d’assistance, les chercheurs ont développé leur propre logiciel en C++ pour traiter les nuages de points 3D capturés par les caméras. « Notre logiciel utilise le kit de développement logiciel Ensenso (SDK) (multi-threaded) et ses routines de calibrage pour superposer les nuages de points haute résolution avec une texture, puis transformer ces nuages de points texturés en un système de coordonnées mondial », explique Naresh Marturi. « Le kit de développement logiciel Ensenso est relativement facile à intégrer dans notre logiciel C++. Il offre une variété de fonctions ou de méthodes simples pour l’acquisition et la manipulation de nuages de points ainsi que d’images de caméra. De plus, les routines SDK avec prise en charge CUDA nous permettent d’enregistrer plusieurs nuages de points haute résolution pour produire des nuages de scènes de haute qualité dans la trame globale. C’est très important pour nous, surtout pour générer des hypothèses de préhension précises. »

Pour le système d’assistance, les chercheurs ont développé leur propre logiciel en C++ pour traiter les nuages de points 3D capturés par les caméras. « Notre logiciel utilise le kit de développement logiciel Ensenso (SDK) (multi-threaded) et ses routines de calibrage pour superposer les nuages de points haute résolution avec une texture, puis transformer ces nuages de points texturés en un système de coordonnées mondial », explique Naresh Marturi. « Le kit de développement logiciel Ensenso est relativement facile à intégrer dans notre logiciel C++. Il offre une variété de fonctions ou de méthodes simples pour l’acquisition et la manipulation de nuages de points ainsi que d’images de caméra. De plus, les routines SDK avec prise en charge CUDA nous permettent d’enregistrer plusieurs nuages de points haute résolution pour produire des nuages de scènes de haute qualité dans la trame globale. C’est très important pour nous, surtout pour générer des hypothèses de préhension précises. »

Les avantages du système en un coup d’œil :

![]() Ce n’est pas l’opérateur, mais le système qui analyse la scène en termes d’accessibilité et de manipulation de l’objet et qui aide l’opérateur à se déplacer vers l’endroit exact où le robot peut le mieux saisir l’objet.

Ce n’est pas l’opérateur, mais le système qui analyse la scène en termes d’accessibilité et de manipulation de l’objet et qui aide l’opérateur à se déplacer vers l’endroit exact où le robot peut le mieux saisir l’objet.

![]() La réponse tactile permet à l’opérateur de sentir le robot dans sa main, même lorsque le robot n’est pas devant lui.

La réponse tactile permet à l’opérateur de sentir le robot dans sa main, même lorsque le robot n’est pas devant lui.

![]() En combinant l’haptique et la planification de la saisie, les opérateurs peuvent déplacer les objets dans une scène éloignée très facilement et très rapidement avec une charge cognitive beaucoup moins importante.

En combinant l’haptique et la planification de la saisie, les opérateurs peuvent déplacer les objets dans une scène éloignée très facilement et très rapidement avec une charge cognitive beaucoup moins importante.

Cela permet de gagner du temps et de l’argent, d’éviter les erreurs et d’accroître la sécurité.

Les chercheurs du laboratoire Extreme Robotic Lab à Birmingham développent actuellement une extension de la méthode pour pouvoir utiliser une main à plusieurs doigts au lieu d’une pince à mâchoires parallèles. Cette évolution vise à accroître la flexibilité et la fiabilité de la saisie d’objets complexes. À l’avenir, l’opérateur pourra également sentir les forces auxquelles les doigts du robot télécommandé sont exposés lorsqu’il saisit un objet. Des méthodes de préhension entièrement autonomes sont également développées. Le bras de robot est alors commandé par une IA et guidé par un système de vision automatique. L’équipe travaille également sur des outils de visualisation pour améliorer la collaboration homme-robot afin de commander des robots à distance via un système de contrôle partagé (Shared Control). En ce qui concerne la sécurité et la santé de chacun d’entre nous, cette approche est prometteuse : la gestion de l’élimination des objets dangereux, tels que les déchets nucléaires, nous concerne tous en fin de compte. En capturant de manière fiable les informations pertinentes sur les objets, les caméras 3D Ensenso apportent une contribution importante à cette tâche de plus en plus urgente et répandue dans le monde.

Les chercheurs du laboratoire Extreme Robotic Lab à Birmingham développent actuellement une extension de la méthode pour pouvoir utiliser une main à plusieurs doigts au lieu d’une pince à mâchoires parallèles. Cette évolution vise à accroître la flexibilité et la fiabilité de la saisie d’objets complexes. À l’avenir, l’opérateur pourra également sentir les forces auxquelles les doigts du robot télécommandé sont exposés lorsqu’il saisit un objet. Des méthodes de préhension entièrement autonomes sont également développées. Le bras de robot est alors commandé par une IA et guidé par un système de vision automatique. L’équipe travaille également sur des outils de visualisation pour améliorer la collaboration homme-robot afin de commander des robots à distance via un système de contrôle partagé (Shared Control). En ce qui concerne la sécurité et la santé de chacun d’entre nous, cette approche est prometteuse : la gestion de l’élimination des objets dangereux, tels que les déchets nucléaires, nous concerne tous en fin de compte. En capturant de manière fiable les informations pertinentes sur les objets, les caméras 3D Ensenso apportent une contribution importante à cette tâche de plus en plus urgente et répandue dans le monde.